Оглавление

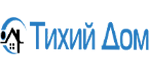

Чтобы понять, как работает поисковая выдача и как поднять ранг своего ресурса в ней, нужно хорошо знать алгоритм работы поисковых систем Google. В этой статье мы попробуем кратко рассмотреть принцип отбора ссылок в выдачу всеми аналитическими функциями и фильтрами поисковых роботов.

Распознавание «живых» запросов

Алгоритм BERT, работающий на основе ИИ, помогает лучше понимать запросы пользователей, написанные естественным языком – без оптимизации под поисковую систему. Как говорил Джон Мюллер, этот алгоритм нацелен на определение языковых элементов вроде предлогов, которые часто меняют картину запроса и которые важны для понимания фразы.

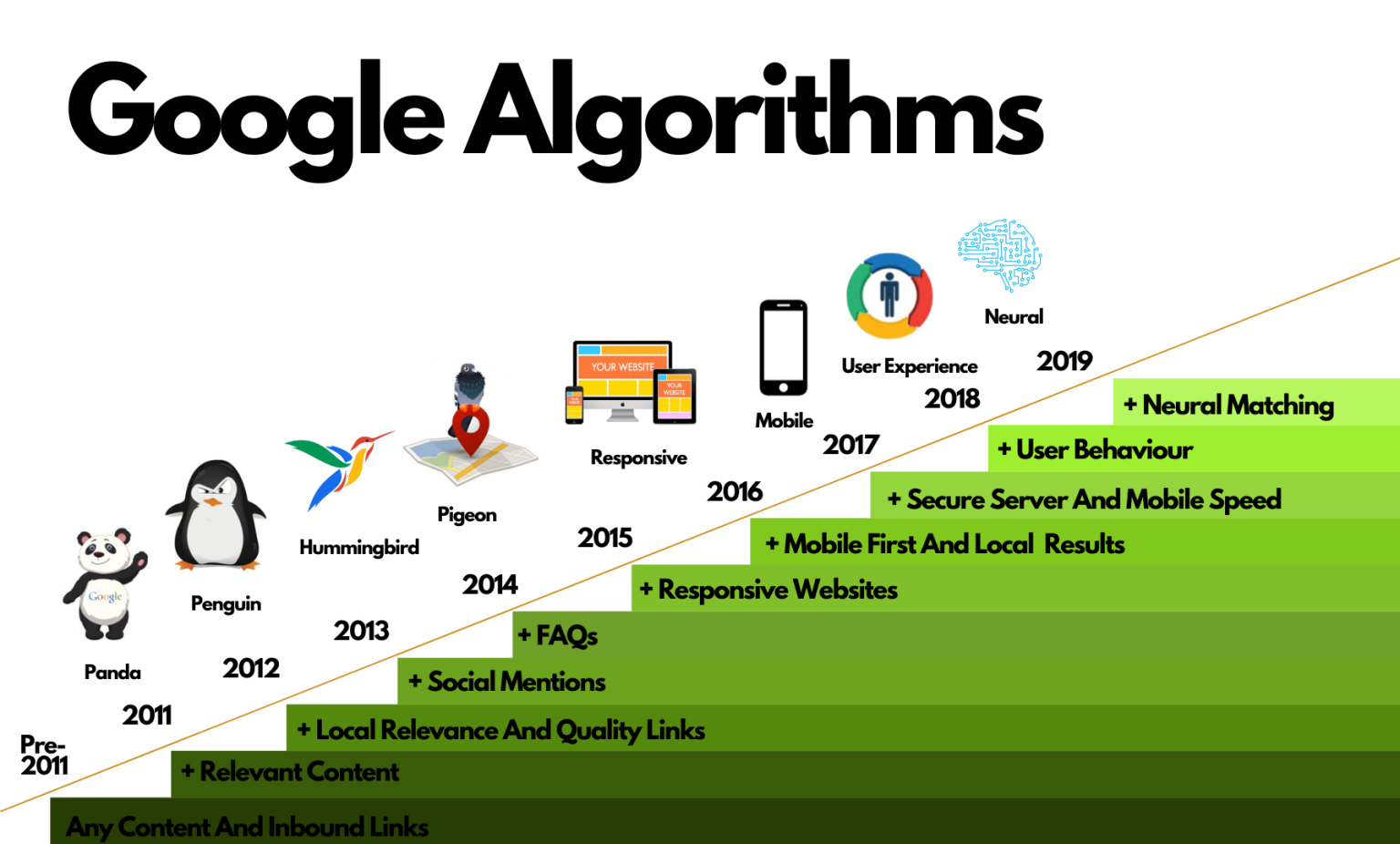

Исключение дублей

Проблема современного интернета, доступного всегда и всюду – большой поток информации, в том числе дублированной. Выводить ссылки на однотипные страницы нет смысла, поэтому поисковые роботы используют алгоритм дедупликации. Приоритет получают те ресурсы, которые обладают качеством по другим параметрам, а низкокачественные дубли исключаются из выдачи. Аналогичный подход работает и для сниппетов: если страница попадает в сниппет, то в основную выдачу ее выводить ни к чему.

Обеспечение разнообразия

Обратная проблема – не забить весь топ ссылок одним и тем же ресурсом, пусть и качественным. Система Site Diversity группирует результаты с одного сайта и выдает не более двух ссылок в топ. При этом основной сайт и его поддомены, разумеется, считаются одним источником.

Проверка на запросы в домене

Модуль Exact Match Domain проверяет домены сайтов на предмет ключевых запросов. Если они есть, то это считается манипуляций запросами (ведь адрес может никак не коррелировать с наполнением страницы), и такое не повышает, а понижает рейтинг ключа.

Ранжирование по актуальности

Во многих случаях информация не обладает снижением актуальности, но нередко это ключевой фактор – например, финансовая информация по биржам за прошлый год обычно пользуется меньшим спросом, чем за последние дни. Алгоритм Freshness анализирует запрос и при необходимости увеличивает ранг для наиболее свежей информации. Актуальность определяется по дате публикации материалов, а также по периодичности и масштабности обновлений.

Ранжирование по качеству

Система Helpful Content Update отвечает за проверку качества страниц в выдаче. Анализируется оригинальность контента и его релевантность. Конечно, некачественные ресурсы тоже попадают в выдачу, но опускаются гораздо ниже. Низкокачественным контентом считается скопированный, заточенный под поисковые системы (высокое содержание ключей), а также тот, где у автора нет экспертности в вопросе, хотя она необходима.

Ранжирование фрагментов

Современный поисковик анализирует не только страницу целиком, но и ее отдельные блоки, чтобы найти наиболее релевантный фрагмент. Нередко случается, что блок из одной статьи более полезен, чем обширная статья на эту тему. За это отвечает модуль Passage Ranking. Подробнее можно ознакомиться тут.

Оценка перекрестных ссылок

Раньше это был важный фактор, оцениваемый алгоритмом PageRank (счетчик PR даже выводился на страницы). Сейчас он влияет на ранг в выдаче в меньшей степени, но все еще работает. Алгоритм оценивает, насколько оправданы перекрестные ссылки и не рекламируют ли сайты друг друга слишком активно.

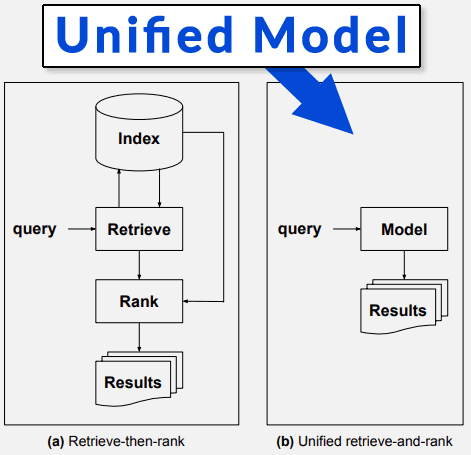

Понимание сложных запросов

На некоторые запросы очень сложно выдать конкретную страницу, потому что на них нет простого и точно ответа. Модуль Multitask Unified Model (MUM) анализирует такие запросы и формирует выдачу так, чтобы смежные ответы на несколько более простых вопросов давали нужный результат. Кроме того, он может, например, искать информацию на других языках, отличных от того, на котором сформулировали запрос.

Сопоставление страниц

К предыдущему модулю примыкает подпрограмма Neural Matching, которая классифицирует запросы и страницы с контентом, чтобы подобрать наиболее подходящее сочетание. Особенно это полезно для запросов, сформулированных простым языком.

Связь запросов и концепций

Система RankBrain анализирует запрос с концептуальной точки зрения, чтобы включить в выдачу не только те страницы, где есть ключевые слова из запроса. Контент может быть максимально релевантным, но при этом без единого нужного вхождения, и поисковик должен вывести его в выдачу, распознавая связь между запросом и контентом без участия ключей. Анализ идет на основе переходов пользователей по ссылкам после похожих запросов. Например, запрос «как общаться с Есениным» сначала выведет ресурсы по соционике, а не по спиритическим сеансам.

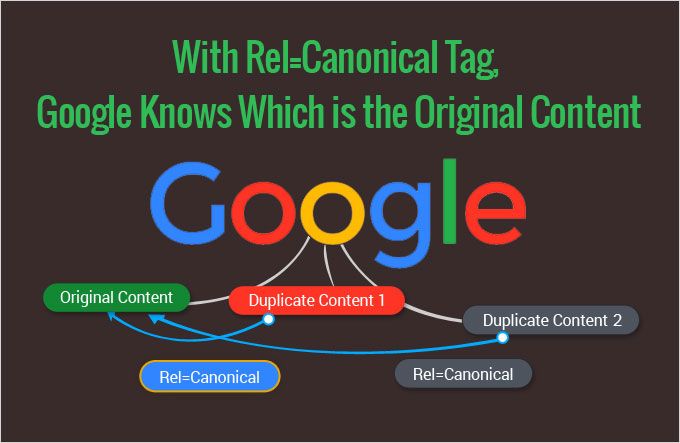

Определение первоисточников

Поисковые роботы стремятся выдать ресурсы-первоисточники, чтобы копирующие контент площадки не паразитировали на авторах. За это отвечает модуль Original Content, анализирующий hreflang и canonical.

Отслеживание запросов на удаление

Система Removal-Based Demotion ведет статистику по запросам на удаление контента. Если в отношении какого-то материала сайта поступает много таких запросов, это значит, что он нарушает какие-либо правила (например, затрагивает персональные данные или авторские права). Страница удаляется из выдачи, а остальные страницы сайта считаются менее качественными, поскольку тоже могут содержать нарушающий правила контент. Также их могут понизить в ранге выдаче при следующих условиях:

- многочисленные жалобы на нарушение авторских прав;

- жалобы на мошенничество, клевету, подделки и т.д.;

- есть запросы на удаление контента с судебным решением.

Производительность и эргономичность

Относительно новый алгоритм Google, Page Еxperience, проводит анализ опыта пользователей, перешедших на страницу – было ли им удобно и просто получать нужную информацию, а также насколько это было безопасно. Оценка идет по множеству параметров: наличие протокола HTTPS, скорость загрузки, наличие адекватной мобильной и десктопной версии сайта, отсутствие навязчивой рекламы. Все параметры оцениваются не по шкале «хорошо/плохо», а несколько более сложно. Например, скорость загрузки оценивается не только в целом, но и поэтапно – основной контент, отрисовка самого крупного элемента, скорость реакции на первые действия пользователя и т.д. Кроме того, оценка идет с точки зрения логики: если скорость загрузки достаточно высока, то дальнейшие улучшения не улучшают ранг выдачи страницы, поскольку они незаметны для пользователя.

Ранжирование отзывов

Отзывы и обзоры на услуги или товары также анализируются поисковиком. Модуль Product Review работает в связке с Helpful Content Update, определяя качество оценок. Преимущество получают отзывы, которые составлены разбирающимися в вопросе пользователями или официальными экспертами. Качественным считается тот обзор, который отвечает следующим критериям:

- автор разбирается в теме (определяется по косвенным признакам);

- анализ сделан подробно;

- отзыв оригинальный, т.е. содержит личный опыт;

- наличие информации об аналогах и/или сравнение с предыдущими версиями продукта;

- наличие медиаконтента (фото или видео).

Безопасность и авторитетность

Алгоритмы модуля Reliable Information следят за тем, чтобы найденная информация не могла нанести вред, а попавшие в выдачу сайты были авторитетны и несли ответственность за свой контент. Например, медицинская информация, поданная неверно или не экспертом в определенной области, может быть применена пользователем, что, в свою очередь, может привести к опасным для здоровья последствиям. Поэтому в отношении подобного контента применяется принцип E-A-T (экспертность, авторитетность, достоверность).

Не так давно произошло обновление алгоритмов Google, и теперь используется система E-E-A-T. Добавился пункт Experience, «опыт». С этого момента поисковые роботы Google применяют Experience алгоритм, чтобы оценить, применял ли автор контента свои собственные методы в личном опыте или рассуждает только теоретически. Если вернуться к медицинской теме, о жизни с какой-либо болезнью может рассказывать не только эксперт (врач), но и тот, кто оценил это на собственном опыте (больной). Такой подход позволяет расширить поисковую выдачу, сохраняя принцип контроля авторитетности и достоверности данных.

Выводы

- Не перегружайте текст ключами, лучше сделайте его читабельнее. Современные алгоритмы способны воспринимать и анализировать естественный язык.

- Текст должен быть уникальным и релевантным, чтобы поисковик не посчитал его мусором или дублем.

- Если для информации важна актуальность – не забывайте обновлять материал.

- Соблюдайте авторские права.

- Отнеситесь к своему контенту критически, чтобы оценивать, насколько он достоверен и безопасен для пользователей.

- Проверяйте техническую сторону ресурса: скорость загрузки, корректность отображения на разных платформах.

Подробнее с руководством по системам ранжирования от Google можно ознакомиться по этой ссылке.